撰文:徐鸿鹄 | 编辑/排版:王晓峰 |校版:胡静文

⚠ 全文总长约含7,000字,预计您的阅读时间为10分钟。

公众号:几何四驱 (ID: GeometryAWD)

对话界面回复“群组” 获取读者“讨论群”入群方式

几何四驱官网:www.WhyBeta.com

核 心 内 容 摘 要

1. 「无人车」不具有自主意识,因此无法独立承载道德风险。同时,无人车作为一个软件密集型产品,概率式的推理方式很难与安全工程的因果式的推理体系达成和解。用法律来惩戒没有自主意识的“物”(无人车)没有任何实际意义。由此,无人车技术便产生了道德真空。

2.「无人车」争议首先要尊重法律。法律是斗争和博弈后的产物,是被经验证明有效的追求公平性的制衡。法律追求的不是绝对正义,因为在公平原则下不存在绝对权威来定义什么是正义。而存在缺陷的立法原则,比如单纯注重公平原则的话,人们反而宁愿放弃让无人车这种更加安全的技术落地。

3. 人类做出的道德判断,基本上是诉诸直觉的,也可以说,人类的道德观念往往是非理性的。但非理性决策并不代表人类低级,恰恰相反,在资源有限的情况下,人类能够从小数据迅速提炼归纳出规律,这正是人类非理性决策的先天优势,是人类思维能力的集中体现。因此,人类必须扬长避短。

4. 在技术还未成熟的时候,给机器“道德编程”会人为地引入“默许选择性牺牲”的预设立场。自动驾驶道德问题的出路就是尽快地普及这项技术,市场竞争和司法实践会源源不断地为推进这项技术走向成熟保驾护航。

5. 在无人车伦理这个问题上,人类是要有道德感的,但更要时时刻刻提防“道德”被“滥用”:不要站在道德的制高点上打压竞争对手;不要以道德为名绑架技术和观点;不要把道德当成一件无形杀人武器。否则,挥舞道德大棒本身将比无人车危险的多。

有人说,无人车伦理是技术观点和哲学观点的冲突。

然而,即便在哲学界,也有水火不容的两种观点占据主流,让这一问题变得更加棘手。

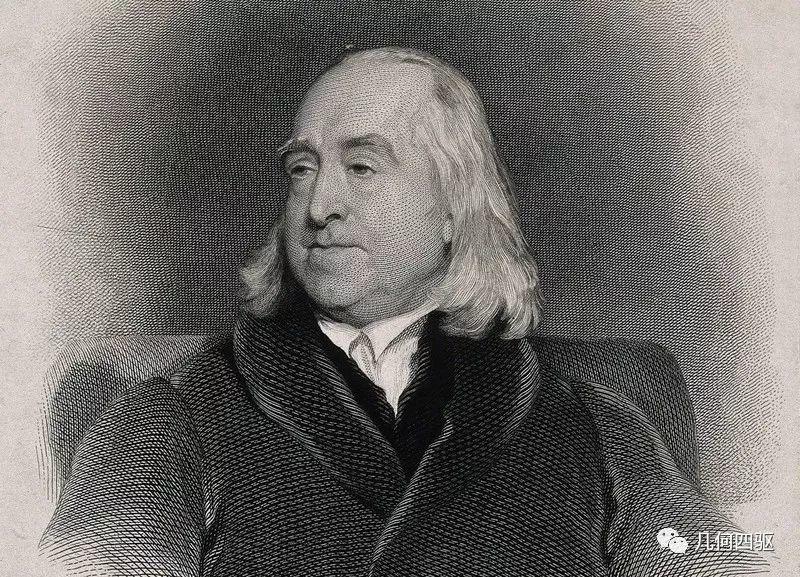

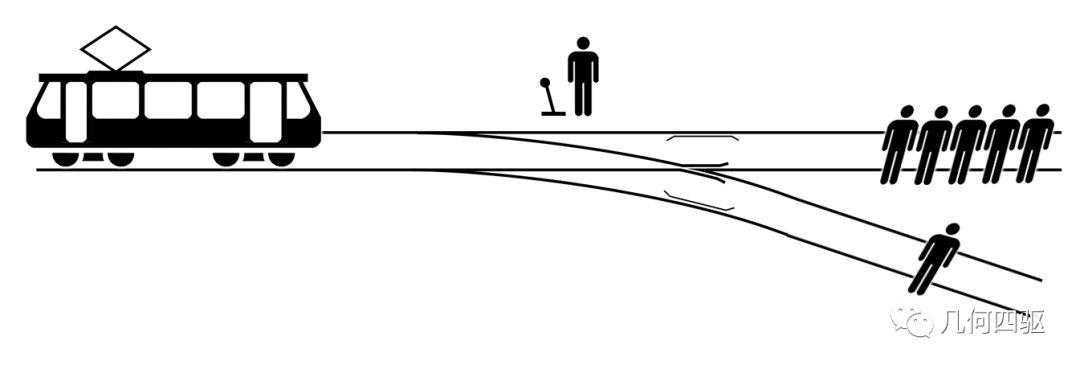

英国哲学家杰里米·边沁和德国哲学家伊曼努尔·康德分别代表了两种历史悠久的观点,而无人车伦理这个命题,又令两人再度交锋。

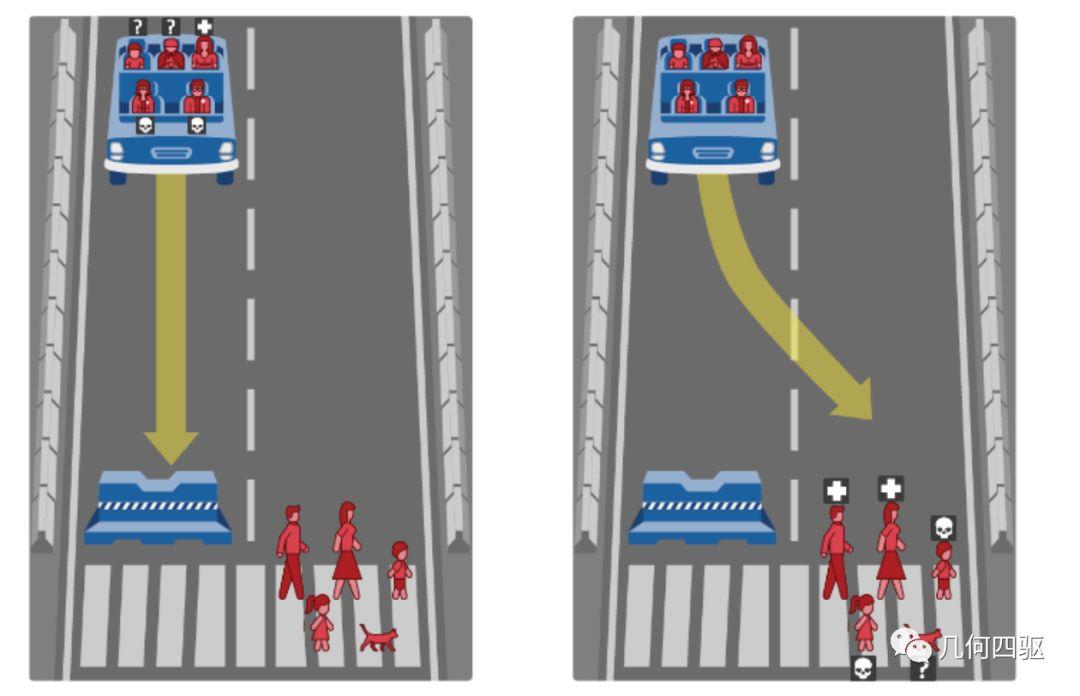

边沁一派的观点认为:车辆应该遵循功利主义道德,即采取最小伤害的行动——即使会牺牲一个无辜者或以乘客身亡作为代价。

伊曼努尔·康德则认为:车辆应该遵循“义不容辞”的原则, 即“不可杀人”。因此你不应该有意去伤害一个人, 应该让汽车顺其自然地行驶, 即使这样会伤害到更多的人。

你会怎么选择呢?支持边沁还是康德?

社会调查得到的结果是这样的:大部分人赞同边沁的观点,人们似乎希望无人车是功利主义的。于是问题似乎解决了。不过这里还有个插曲:当调查者讯问大家会不会买这样一辆车时, 他们却都不约而同地回答,“绝对不会”。

调查者终于弄懂了:原来,人们更希望买能够不顾一切保障自己安全的车, 并指望其他人都买能将伤害降到最低的车。

这个陈述在历史上曾经被一次次地反复提出,除了无人车伦理外,过度捕捞,应对气候变化的碳减排,都可以被看作是同一类社会问题。早在19世纪,英国经济学家威廉·福斯特·劳埃德在他的宣传册里就描写了这样一个故事:

有一群英国农场主, 共同在一片地里放羊。 如果每个农场只养三只羊, 这片土地上的植被就可以正常再生, 羊群也自在逍遥。 如果有一个农场主多放了一只羊, 他就会获益更多, 不过其他人也都没什么损失。 但是如果每个农场主都擅自增加羊的数量, 土地容量就会饱和,变得不堪重负, 所有农场主都会受损, 于是,羊群也会开始挨饿。

只要我们把羊群换成无人车做类似的比喻,就会意识到,无人车的制造者很可能会简单的把行车电脑程序设定成最大限度保护车主的安全,这无形中会略微增加对行人的潜在危险。

在无人车进化的道路上,这肯定不是我们的初衷,可谁能够为我们指引未来正确的方向呢?

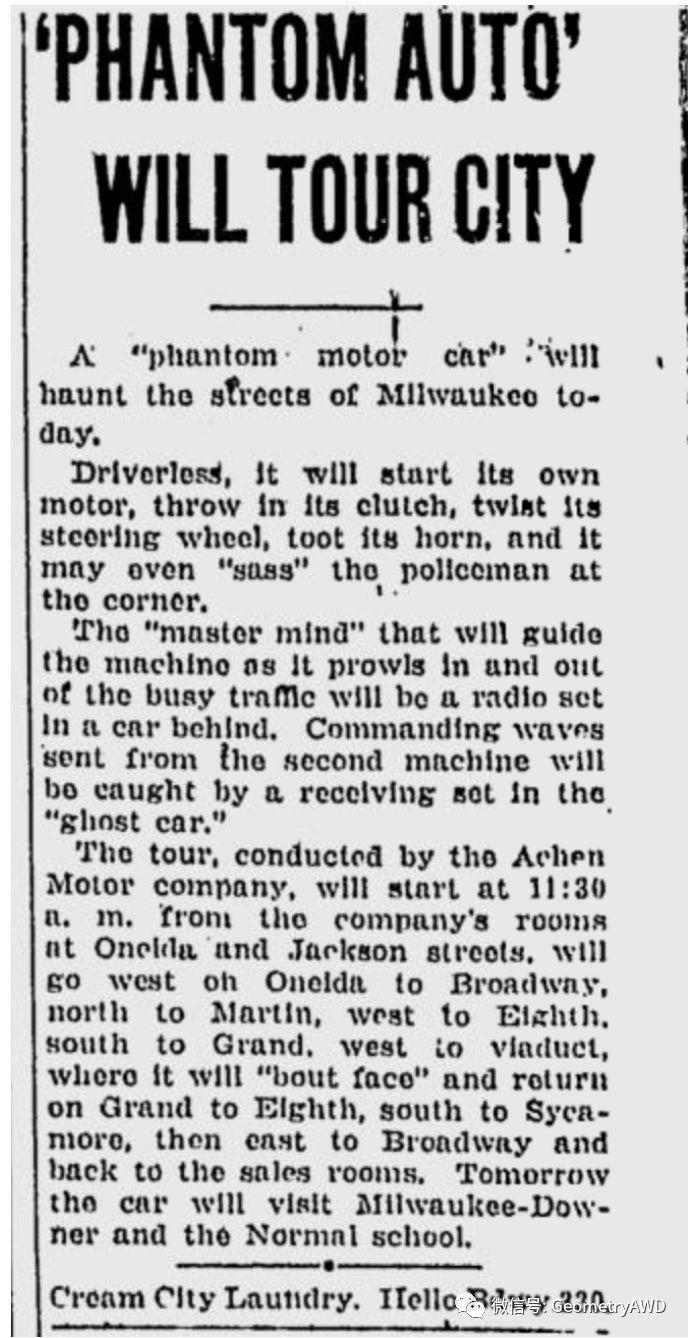

[1] 1926年12月8日,密尔沃基哨兵报(Milwaukee Sentinel)刊登了一篇“幽灵汽车城市巡游”的告示,借助无线电远程控制的方式,操控一台“无人驾驶”的汽车穿行于密尔沃基的城市街道。

这似乎是能找得到的最早的关于无人车的报道了。

可明眼人还是会指出,这似乎只是商人们的投机和炒作——遥控汽车怎么能跟无人车划上等号呢?

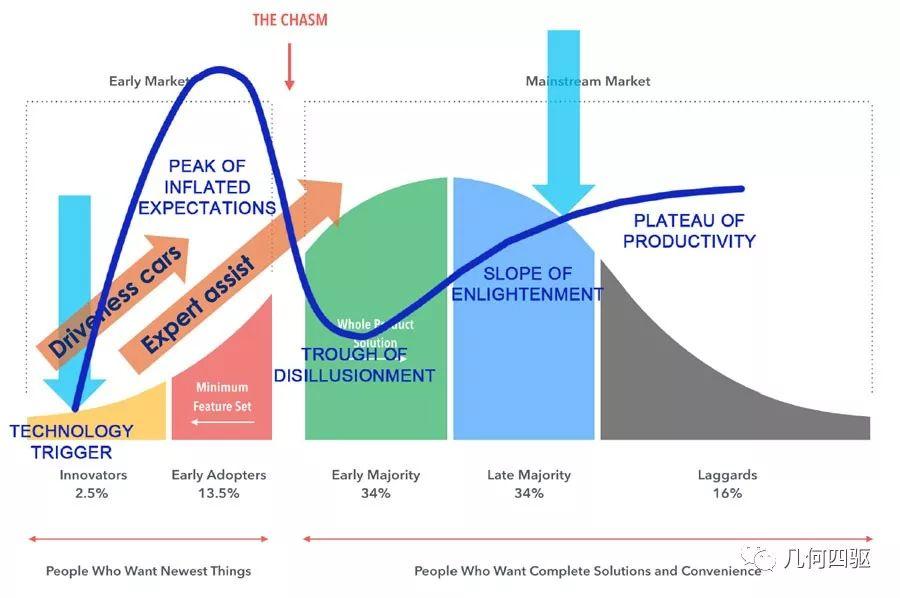

随着人类科技树的持续点亮,直到进入21世纪,无人车才真正变成了全世界所有人都在热议的话题,这次不仅是夸夸其谈,也有现实的产品和方案。一切都给人一种错觉:分分钟就会有颠覆性的产品出现并彻底改变世界。

至此,人类看到了新的可能:历史上第一次,人类将自己的生命权托付给机器智能以换取便利 !

基于这一探索,我们有理由相信:一旦「自动驾驶」技术成功应用,今后人类将大概率地无条件信任其它人工智能产品。

可是,人类为此做好准备了么?

「是技术中的道德真空?还是道德中的技术真空?」

不同于人类的思维方式,机器更加擅长基于预设的规则批处理指令,IF条件判断语句和THEN执行语句即可组合成基本计算逻辑。

在复杂的无人驾驶场景里,比如环境多变的城市道路上,充斥着交通信号灯,标识,行人,非机动车,路障还有加塞和多变的天气,通过穷举所有的组合条件调取预设命令触发执行机制的方式已经无法有效运作。

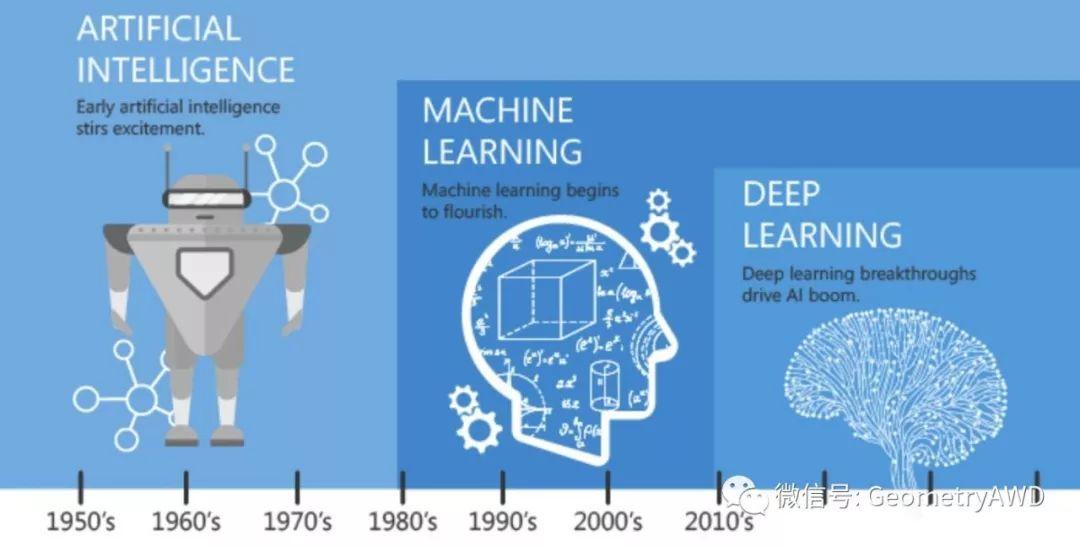

上世界80年代开始,机器智能开始加速进化,在完成从逻辑到知识的跨越之后,计算机又被人类赋予了自我学习的能力:

不需要人为的指导,机器就会自主决策!

[2] 2006年开始,机器学习的一个重要分支,深度学习技术的突破裹挟着颠覆性的应用席卷了整个人工智能产业,这些创造旨在松开系在机器上的枷锁,让它潜入数据当中,自主地探索和体验,无人干预地寻找数据模式和关联,最终能够预测未来的行为,后果乃至趋势。

某种程度上来说,人类赋予了机器思考的能力,使其参与了决策的过程。

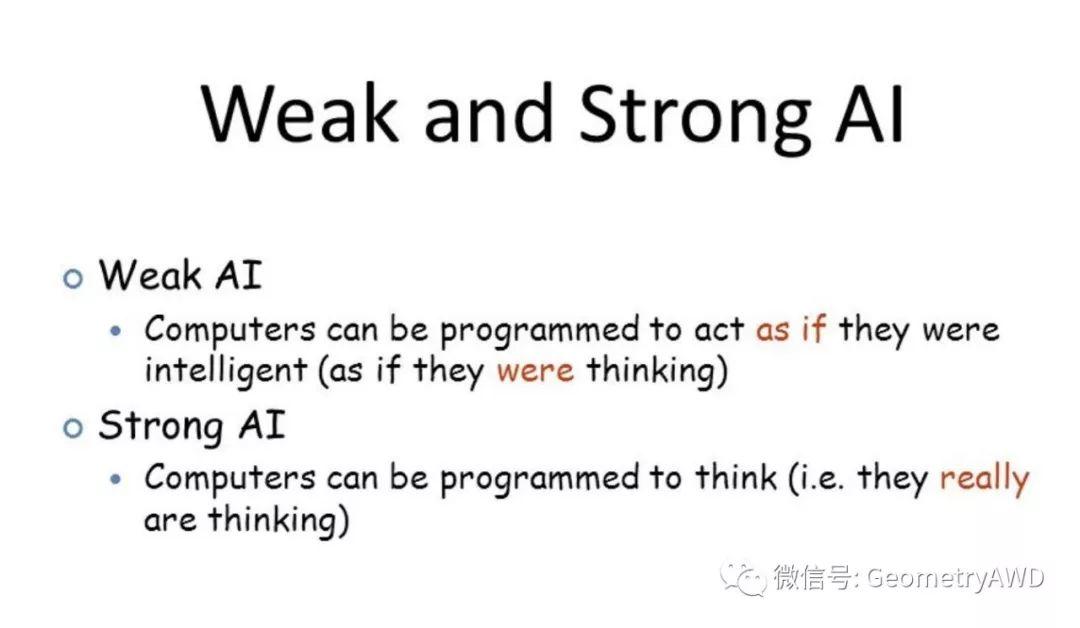

决策过程从此实现了人类与计算机的共同助力,暂且把这种技术和人合作的智能体叫做 [3] 弱人工智能。

之所以称作弱人工智能, 就在于它没有人类所具有的那种主观意向,因为他不能够完全自主地有意识地去做某些事,但却具有一种物质形式的客观意向性。

就好比怀孕的妇女在决定是否堕胎时,产科的超声波技术扮演了“参与到”决策当中的作用,最终决定是孕妇做出的,但超声波技术却以物质的形式间接参与了决策。

机器智能的进步正积极地影响着它的使用者,并且改变着使用者感知世界的方式。弱人工智只有被赋予了自由意志,和人类一样平等享有自主决策的能力和权利,才会成为强人工智能独立为新的物种。

无人车「自动驾驶」的智能系统被构建成具有应用领域特定问题自主学习能力,以深度学习为例,它在不断累积的“车辆和环境数据”与“人工干预”中持续锻炼“学习模型” (如交通灯车道线交通标示识别,障碍物行为预测,人机交互等子任务),最终使它拥有一定的自主性从而成为弱人工智能的典型代表。

无人车被允许从自己的“训练记忆”和“运行经验”中不断优化自己的“决策能力”,设计它的程序员与决定使用它的管理者引入了模糊的逻辑并不亲手设定策略,而是通过奖惩机制让机器慢慢掌握输入数据与输出行为之间的相互关系,于是有趣的事情发生了:

机器开始产生类似于人类思维的过程

不过,人类程序员为机器预设的学习模型和训练数据,其实早已决定了无人车所做选择的倾向性:机器的自主决策能力受制于先天训练水平和奖惩机制的选择。

[4] 无人车作为弱智能,当面临两难的抉择时,自身并不具备完全独立的主观自主意识(机器的自由意志),却在千钧一发之间被放在了决策者的重要位置,无人车作为单纯的技术“物”不得不由此担负起人类的道德风险。

[5] 在无人车这个技术实践的尝试里,主体性与客体性,人类与非人类共同交织在了一起。

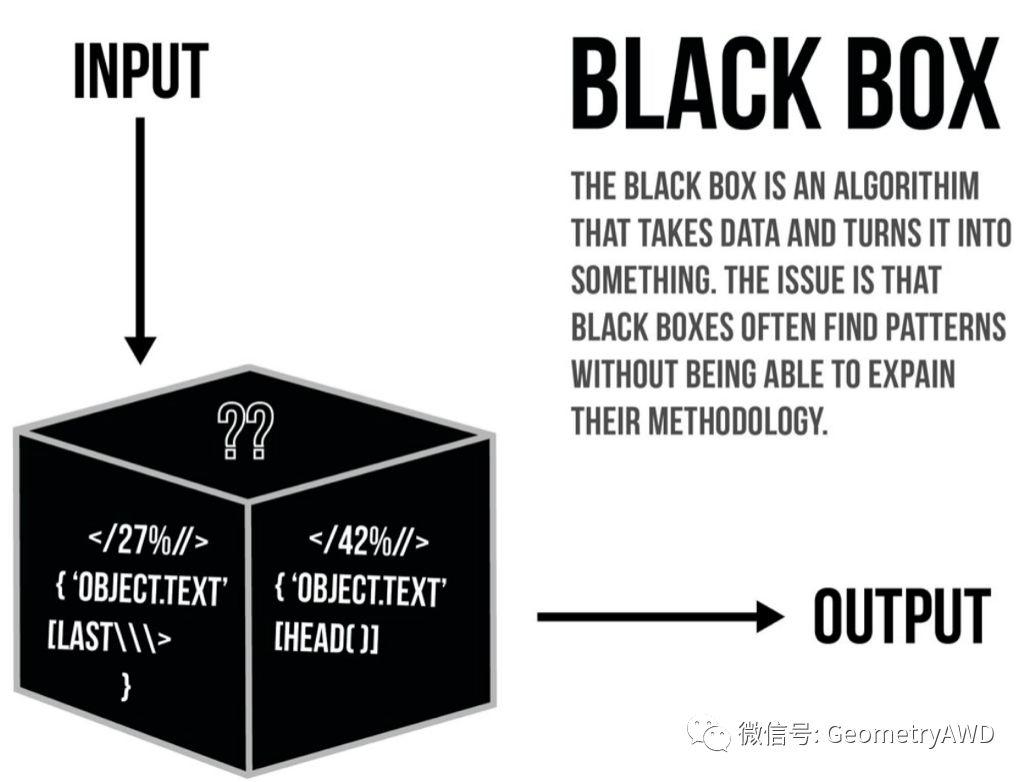

弱人工智能采用的机器学习算法“黑箱”的特点,无形当中成为了智能“物”设计者和管理者推卸自己责任的借口,将安全风险转移给了使用者。

人类能够掌控的只是有限度的智能,那些精巧的程序可以是得力的助手,却不是决策的主人。现有的程序帮助我们获得了有限的成功,却也更加证明了人类的无知。

实际上,无人车不具有自主意识因此无法独立承载道德风险,用法律来惩戒没有自主意识的“物”没有任何实际意义,由此,技术便产生了道德真空。

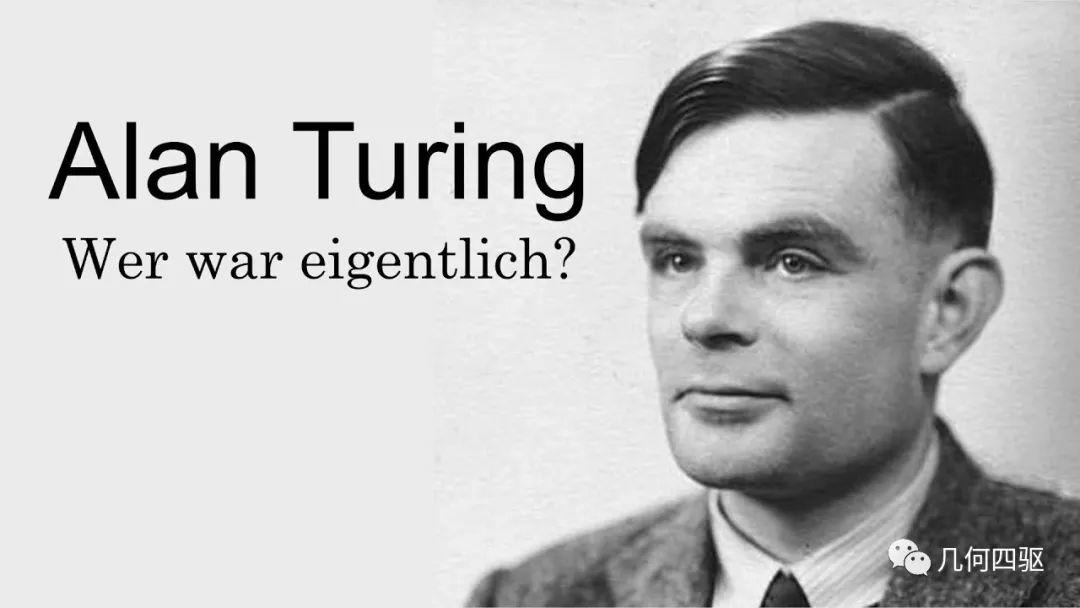

图灵早早就证明了,如果人类的心智是可计算的,它就可以表达为一个图灵程序,技术上就可以使用一台传统计算机进行处理。然而,探讨图灵问题有一种不好的倾向:它常常将我们引向哲学,心理学和社会学,从而带来道德争论。

对于无人车这种软件密集型的产品来说,现有的软件工程方法在安全方面的考量并不完善,软件工程和安全工程之间还存在安全真空。无人车的感知和决策过程,大多采用机器学习的概率推理算法,只体现了相关性,如果从安全的角度出发,则必须设计更加严格的因果推理。

无人车作为关键安全系统的具体应用,软件复杂程度相当高,详尽的软件测试几乎不可能,依赖传统汽车行业通行的最佳安全实践也显得捉襟见肘。这些都需要通过建立新的实践和方法论来弥合。

而为了解决实际问题,我们必须回到机器本身的领域里谈论智能本身。因为在具体业务实践当中,信息的处理仍然受到程序思想的控制,而这就很难绕开德国数学家莱布尼茨代表的机器化思维——一切皆可计算。在这个语境下,我们就很难在智能领域获得更大突破。

即便我们已经了解到智能本身的复杂性,我们对高度智能化仍然心存幻想。

这种可能性之所以存在,一部分正是因为我们人类也是伟大的梦想家。

创造无人车的几代工程师们,就像那些在生物实验室里试图创造人工生命的研究者一样,应该对我们试图理解和模拟的东西怀有虔诚的敬意。

「法律与道德,何去何从?」

自动驾驶,有亟待澄清的法律问题,比如:[6] 无人驾驶这项技术与私人属性的关系,似乎这两者存在天然矛盾:

私有性质的自动驾驶的汽车(产权属于A)在自动驾驶过程中捎带上了乘客B,并在行驶过程中发生了事故并造成A和B的人身伤害,如何进行责任认定?A和B需要向谁索赔?

这类问题是奥巴马一直所说要解决的法律问题之一,“驾驶”是一辆车私有属性的唯一保证,如果没有这个概念,汽车的私人属性就不存在,汽车就变成了“公共”汽车。

无人车相关的法律得以建立精确的体系,是需要长时间高密度大强度的普通法,科学研究,媒体专业实践共同努力,经受诉讼双方利益的尖锐对抗考验后才可成型的。处于灰色地带的法律问题,会被控辩双方精确辩论并诉讼修正,最终固化为成熟的法规条文和司法实践。

对于任何争议首先要尊重法律,尊重法律才能求同存异,理性交锋。法律是斗争和博弈后的产物,是被前人证明有效的追求公平性的制衡。法律追求的从来都不是绝对正义,因为在公平原则下不存在绝对权威来定义什么是正义。

美国对待无人机自动驾驶技术的态度,正体现了这种制衡:

一边,是宪法给予公民的最大自由

一边,是大法官在典型判例中始终把持的公平原则

新的技术因而在双方的制衡中在美国孕育。

就以开篇的例子为例:

公平原则说:无人车应该采用功利主义来进行立法,即总伤害最小,即便这会伤害到驾驶员或行人。

最大自由原则说:如果国家要制定功利主义的无人车规则,那公民们绝不会支持这项技术。

可见,单纯遵循最小损失的原则,最可能的结果就是让人们放弃这种更加安全的技术——即便技术本身是好的。立法的不足带来的反而可能是更大的损失——扼杀一项优秀的技术。

我们感兴趣的是,道德是否也同法律一样,具备约束效力呢?

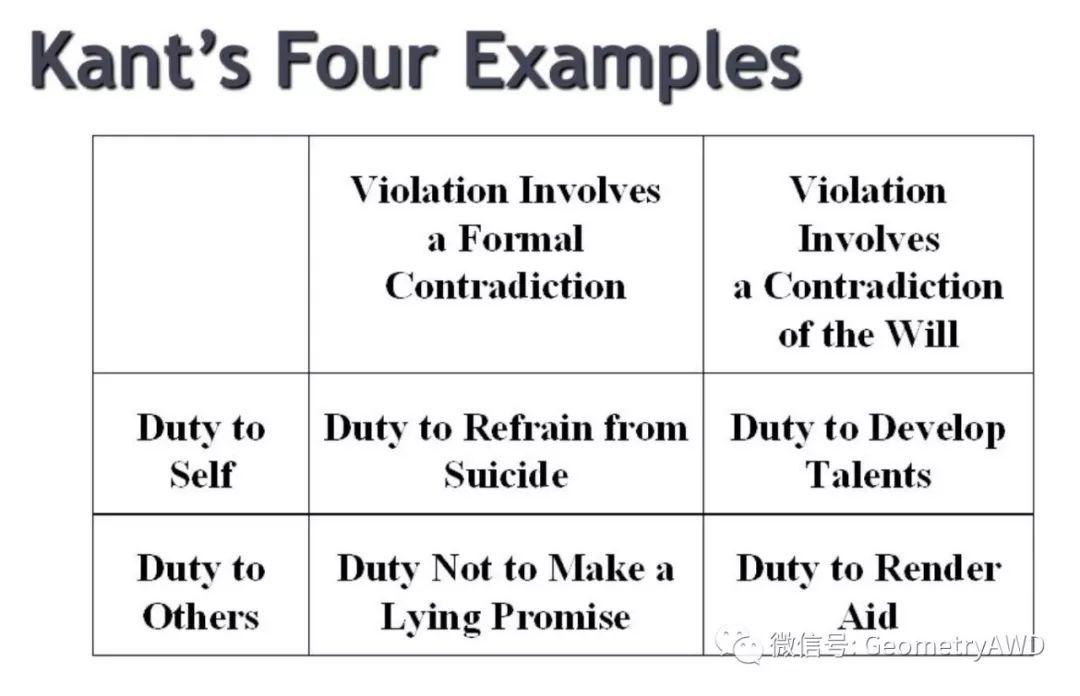

康德曾经通过四个例子对什么是真正的道德行为加以解释:

- 做买卖童叟无欺(对他人的消极义务)

- 不放弃自己的生命(对自己的消极义务)

- 帮助他人(对他人的积极义务)

- 增进自己的幸福(对自己的积极义务)

可以看到,道德不是真理,道德只是一种选择,可以是一种追求个人幸福的选择,可以是一种不触犯法律侵害他人利益的选择,可以是一种在不侵害他人利益的前提下,追求自身利益最大化的一种原始利己的动机。

正是由于道德并非真理,因此个体的道德很难分出对错。《三体》小说里,程心是一个非常普通三观正得没法再正的的正常人,她在每个关键时刻做出的选择是每个正常人会做的选择,符合普世价值观和大众道德取向,但恰恰是这种道德模范一般的人的选择把人类推向了灭绝。

康德认为,一个行为的道德价值不是由结果赋予的,而是与行为的动机有关,即“善良意志”。然而康德到底多大程度上将动机的善恶当作道德价值的评判标准,这还没有定论。

而且,关于道德的准则有很多种。波斯纳大法官曾经说过:“除非简化为事实问题,否则,对有争议的道德问题,不存在令人信服的答案。”

这是说,道德不存在“制高点“!

道德可以是一种自我约束,但却并不像法律一样具有强制的约束力,并不是一种义务。

如果将无人车这项技术交给没有承载“义务”的“道德”的话,你还敢轻易尝鲜么?

「认知科学的奇袭」

如果“电车难题”,这种绝对抽象化的道德题目,只能看做是哲学家用来思辨的小把戏的话,似乎更务实的出路,是从认知论的角度来分析这一新兴技术。

道德是否有其现实意义?如果有,怎么才能有效指导实际应用呢?

借助神经磁震影像技术的帮助,认知心理学领域曾开展了一系列的实验,[8] 有研究表明,在电车难题里,当搬动转道器手柄的可能性被强调时,是大脑的理智区域在做反应,而当强调会造成牺牲的后果时,却是大脑的情感区域产生了反应。

[9] 进一步的研究更探讨了电车难题里“道德决策“与人类出于进化的本能“排斥暴力行为“两者的关系,这种排斥感会激发人类特定的情感反馈机制,这一研究间接暗示了道德决策可能是一种低级的条件反射行为。

也就是说,直觉并非总是通过理性而判断的。

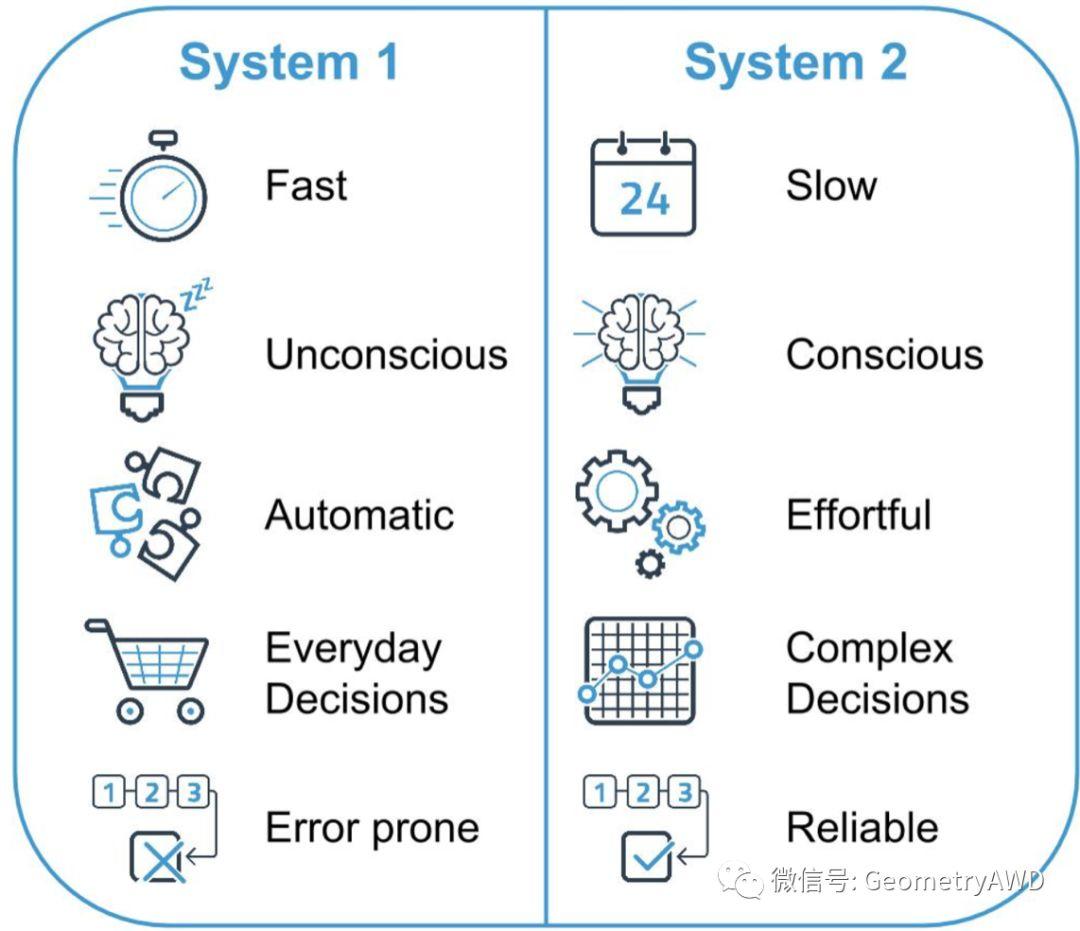

也许,在人类的伦理学中,并不存在直觉所依托的“基础原理”。心理学家丹尼尔卡曼尼将人类大脑分为两个系统,依赖直觉的“行动者”和依赖理性的“思想者”,传统观念将道德看作理性的结果。

基于这个行动者—思想者的模型,[10] 认知科学家乔纳森海特通过实验发现认知常常是直觉部分的工作,理性部分更多参与“事后辩护”。

“聪明并不会让你更加正确 — 它只会让你更好地说服自己和别人自己是正确的。”

更进一步地,当乔纳森海特利用记忆数字的任务让理性的部分“饱和”时,再进行价值判断的速度并没有受到显著的影响,这也说明了人类做出的道德判断,基本上是诉诸直觉的,换句话说,人类的道德观念往往是非理性的。

非理性决策并不代表人类的低级,恰恰相反,在资源有限的情况下,人类能够从小数据迅速提炼归纳出规律,这正是人类非理性决策的先天优势,是人类思维能力的集中体现。

那么,人类又该如何扬长避短呢?

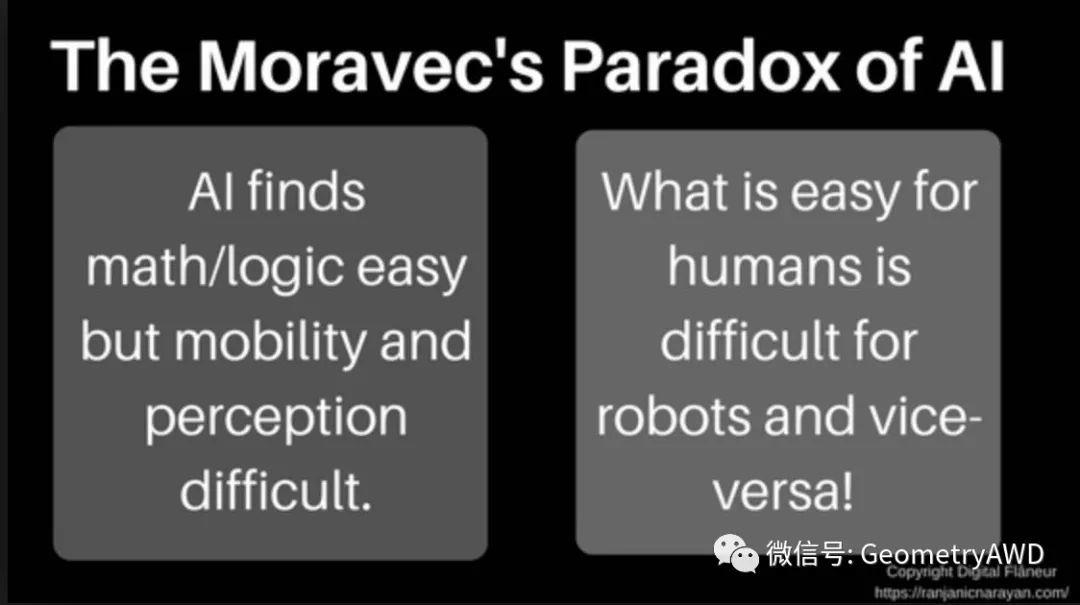

莫桑维克悖论为我们指明了一个方向,它阐述了一个很有意思的原理:不管是人类还是机器,高级推理所需要的计算量不大,而低级的感觉和运动技能却需要庞大的计算力。

恰恰正因为如此,人类更应该本着务实的态度,将无人车当作人类四肢和眼睛的物理延伸来支配,释放脑力将感觉、运动、计算的底层计算力交给更厉害的无人车。

“亲爱的TX65,你是否可以告诉我下面这个方程式的解是什么?” “很简单,10.1707872844”

但是,如果人类不负责任地将「伦理决策」也交给无人车并将其看作人类道德的转嫁物,我们的目的就变成了可怕的“机器取代人类”,而不仅仅是“机器取代人类不擅长的工作“。

人类“懒惰”的代价不应该是“牺牲道德”,在无人车伦理这个问题上,人类还是应该有道德感的,而且要时时刻刻提防“道德”被“滥用”:不要站在道德的制高点上打压竞争对手;不要以道德为名绑架技术和观点;不要把道德当成一件无形杀人武器。

否则,挥舞道德大棒本身将比无人车危险的多。

「通向实在之路」

人类不应该对没有道德判断能力的弱人工智能机器挥舞道德的大棒,苛求它在实际应用之前达到极端完美。面对危机的一刹那,人类驾驶者往往会依赖本能的反应,而不会去主动考虑“电车难题”里的道德哲学问题。

在面对道德难题时,作为道德僵尸的弱人工智能无法抉择,弱人工智能没有自由意志成为道德的承载物,因此创造并使用它的人最应该受到道德约束。

与其追求一个100%完全正确的驾驶机器,人类不如更现实一点,期望机器在对自己的答案不确定的时候,机器能够明确向人类表达出它的局限性,并由技术开发者来承担机器“无知”而带来的法律后果。

“我不知道” 比一个错误答案更显珍贵。

人类对于自动驾驶技术的要求比对人类自己更苛刻,这无可厚非,无人车的感知范围,计算力,反应速度,失效率无一不领先于人类。在人类出行最大的两个痛点交通事故和交通拥堵上,无人车都给出了更优的解决方案。

可是,如果在技术还未成熟的时候,就考虑给没有道德判断力的机器强力编程实现特定的道德束缚,会人为地引入“默许选择性牺牲”的预设立场,从而主动带来不可控的道德风险。

为解决自动驾驶道德问题,最现实的出路就是尽快地普及这项技术。市场竞争和司法实践会源源不断地为推进这项技术走向成熟保驾护航,而道德审判只会带来纷争和无解的局面。

未来我们将更有可能看到这样的趋势:

-

只要自动驾驶的实际性能超越了统计意义上人类司机的平均水平,科技价值能够得以体现,这项技术就是值得推广的。

-

顾虑无人车安全的人仍然可以保留自己开车选择的权利,以确保个人最大自由。

-

无人车上路,虽事故不断但法规建设日臻完善。

-

道德建设上,人类已经开始致力于确保无人车智能不会被别有用心的人用于邪恶的目的。

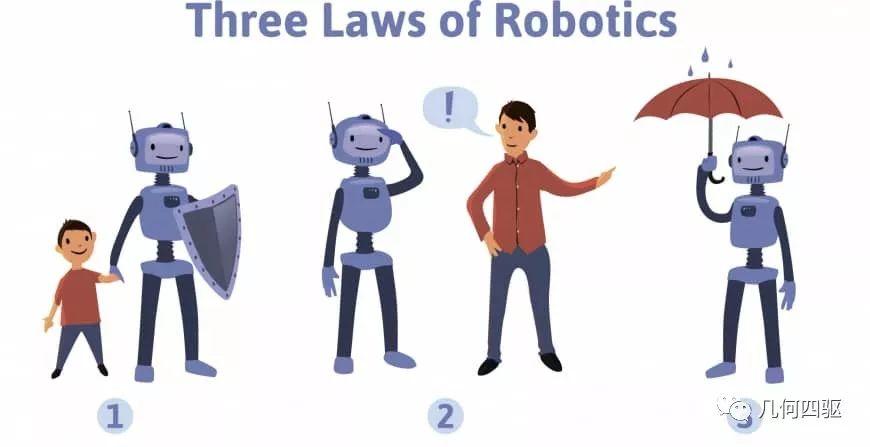

在20世纪40年代, 艾萨克·阿西莫夫就写下了他那著名的机器人三大法则,这三点是岸重要性由高到低排序的。

-

机器人不能伤害人类

-

机器人不能违背人类的命令

-

机器人不能擅自伤害自己

但太多事件一直在不断挑战这些法则的底线。比如,2016年,MIT的Media Lab推出了一个叫“道德机器”的博弈测试,网上的400万名志愿者都要面对加强版的“电车难题”做出选择。

结果显示,由于实际上每个人的道德标准都不相同,因此很难直接判断谁对谁错。这似乎意味着,阿西莫夫小说中的通用机器伦理并不是人类的共识。

于是又有了阿西莫夫第零法则, 凌驾于之前所有法则之上——机器人不能伤害人类这个整体。 问题在于,似乎更没人能说得清,在无人车时代,这个新法则所代表的意义,更不要讲如何去实践它了。

但我们已经至少认识到,针对无人车的立法不仅仅是个技术上的, 还是一个社会合作的问题。如果我们真的像MIT的“道德机器”测试题一样给无人车设计这样一个“撞击优化算法”,指挥它放过哪些车/人、撞向哪些车/人,那这算法简直就是军事武器系统里的“靶向算法”,简直要挑起第三次世界大战了。

解决道德困境并非无人车面临的最大挑战。大众们可能已经对无人车产生了错误的期望,如果他们发现技术发展的“不对头”,一定会大为恐慌。纠正民众的错误期望,才是无人车设计者面临的更大难题。因为不管无人车在道德困境中做何选择,都不可能让所有人满意。

我相信,无人车必将落地,问题也会得到解决。而在解决问题的过程中,我们必须牢记:无论技术多强大,最终受益的或受害的,永远都是它的发明者和使用者 - 人类自己 !

延伸阅读 / 引文出处

[1] 无人车的历史 Wikipedia: Autonomous car https://en.wikipedia.org/wiki/Autonomous_car#History

[2] 2006年—深度学习的起点 http://book.51cto.com/art/201710/554969.htm

[3] weak AI https://en.wikipedia.org/wiki/Weak_AI

[4] 技术物是道德的行动者吗?维贝克“技术道德化”思想及其内在困境 东北大学学报 2017年第3期 刘铮

[5] 费尔巴哈《未来哲学原理》及《哲学改造的临时纲要》中对人的主体性和客体性作出了多方面的规定和说明。

[6] 网络文章《我为什么对自动驾驶说不》 作者已经不可考

[7] 电车难题最早是由哲学家菲利帕.福特(Philippa Foot)于1967年发表的《堕胎问题和教条双重影响》论文中提出来的,用来批判伦理哲学中的主要理论,特别是功利主义。功利主义提出的观点是,大部分道德决策都是根据“为最多的人提供最大的利益”的原则做出的。详见哈佛大学哲学课对电车难题的讲解!

[8] Greene, Joshua D.; Sommerville, R. Brian; Nystrom, Leigh E.; Darley, John M.; Cohen, Jonathan D. (2001-09-14). “An fMRI Investigation of Emotional Engagement in Moral Judgment”. Science.

[9] 《伦理学思想实验中道德直觉的规范性效力问题》 李裕晨

[10] Emotions Rule: How Jonathan Haidt Can Help Us Have Better Relationships https://collegeinfogeek.com/emotions-rule-jonathan-haidt/

特邀撰稿:徐鸿鹄

作者微信:honghu967935

现就职于某德汽车钢铁集团,负责电动助力转向系统开发与管理。

汽车行业11年从业经验 ,研究侧重点主要为底盘电控系统,无人车算法,功能安全等。热爱物理,数学和科学哲学,乐于使用物理学思维和工具解决工科的问题。关注历史,经济学和艺术,跨越学科的藩篱,看见世界感受成长。

更多相关文章推荐

-

Part 3 | 无人车安全之战 — AI觉醒的前夜,人类还在沉睡?

关注「几何四驱」

各种高能文章,随后速速就来