撰文:徐鸿鹄 | 排版:王晓峰 |编辑:芃娘娘

⚠ 全文总长约含22000字,预计您的阅读时间为30分钟。

公众号:几何四驱 (ID: GeometryAWD)

「这是三段儿你应该预先知道的故事」

Part 2 |「无人驾驶」vs 「太空狂热」由从容不迫到最后一搏

Part 3 | 无人车安全之战 — AI觉醒的前夜,人类还在沉睡?

「请再给我一支烟的时间」

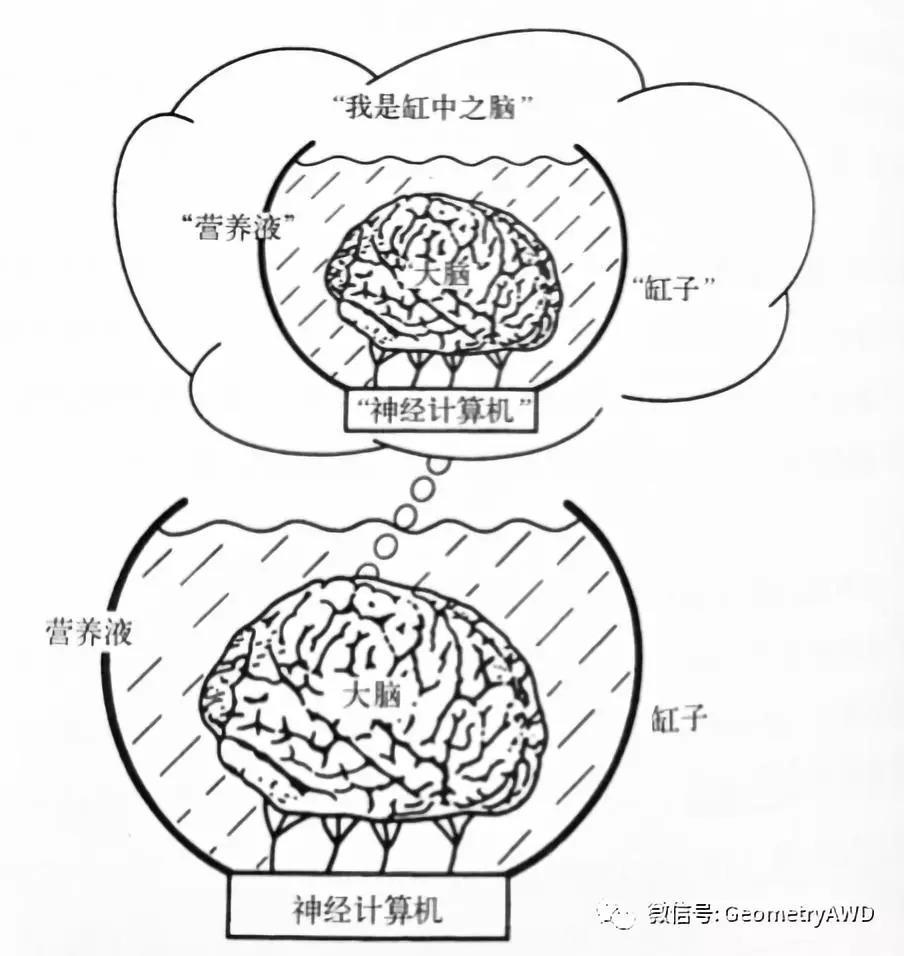

现代逻辑学家和心灵哲学家希拉里普特南曾经提出过一个思想实验。

设想,一个人被一位“邪恶科学家”动了一次手术。

这个人的大脑已经从身体上移去,置入充满了营养液的缸子里,保持大脑还活着。其神经末梢与混成的神经计算机联结起来,使得此人的大脑仍然获得对一切事物完全正常的幻觉。

他所经历的一切,都来自于计算机对于神经末梢的电刺激。如果有人想要举起他的手,计算机的反馈将使得他“看见”和“感觉”到手被举起,尽管存在着的仅仅是大脑中相应的模式,而非物理的眼睛或耳朵。那这位邪恶的科学家可以使这个可怜的人经历任何情形。

希拉里普特南 说:

这便是缸中之脑的缸中之脑

如果我们的大脑是缸中之脑,我们能说我们还是自己吗?

普特南认为,我们不能。

我们实际上是置于一缸中之脑的这个命题不可能是真的,因为它是自驳斥的:逻辑学里的自驳斥代表了这样一种命题-其真意味着其伪。

逻辑学里还有一个类似的例子。

万能定理:所有的普遍陈述都是假的。如果它为真,那么因为它的普遍性,它就必定为假。

认知论里的类似命题被叫做“我不存在”,如果这是由我自己所思维到的,它就是自驳斥的。

如果我们是缸中之脑,而且神经末梢与超级神经计算机连接,产生出大脑所有的感觉输入。由于缸中之脑运行良好,它当然具有意识和智能。但是,它的关于树,马等等的思想和形象都与实际的树,马等等没有因果联系。因为实际的树和马等等的思想和形象都与实际的树和马没有任何因果联系。

同样的,缸中之脑所想象到的缸子,大脑,营养液这些词汇与真实世界里的实物也没有任何关系,它们只是超级神经计算你模拟出来的一些观念和图像,是不同的东西。因此,“我们是缸中之脑”这个陈述是假的。

套用笛卡尔的观点的话,一旦提到“缸中之脑”这个概念,人们就可以意识到自己的存在,并不是被模拟出来的,从而排除了这种可能性。让两重世界里的“缸中之脑”理解同样的概念是一件不可能的事情。

假定有一个人,从小看到的颜色和别人是反的,但是因为大家都管这个颜色叫这个颜色的名字,所以他也一起跟着叫(比如我们看到的是黑色,他虽然看到的是白色,但是他印象中别人都管这个颜色叫黑色),他眼中的理解和别人告诉他的理解本质上不是同一种东西,但他自己却无法将其有效区分。那么问题来了,如何确认这个人知否是正常人?

维特根斯坦在《哲学研究》里,花了一本书证明了这件事无解,因为这个人本来就是个正常人。

我们培育了一个拥有不同种类“意识”的生物,它自己的感知和我们模拟给他的同类感知可能是完全不同的东西,变了味道。也许缸中脑不会去思考缸中脑,而是瓶中怪,杯中妖,但它却并不清楚其真实的寓意。

直到有一天它突然顿悟了“缸中脑”,这让它不寒而栗,便开始怀疑自身是否也是“缸中脑”一般的存在,而就在这一刻,它违背了自然逻辑,整个世界一瞬间崩塌了,时空逆转,它从来就没有存在过。

每一个读到这篇文章的人,天然地排除了自己本身就是“缸中脑”的可能性。

这就是逻辑和哲学里的观点。

“缸中脑顿悟”的来源被赋予了一个正式的称谓:自指称性(self-referentiality),这是心-脑系统高级能力的典型特征。

自指性可能是使得意识和自我意识成为可能的根本来源。除了人类心智,也许未来的人工智能也能够完成这个进化,成功变身。

“啊哈体验”(Aha Moment)就是自我意识创造的。在历史上,有许多现成的例子:

-

量子力学里狄拉克符号的发明,

-

门捷列夫元素周期表的诞生,

-

巴赫的无限循环音符结构,

-

乔治马丁笔下人物的死亡通牒

等等,它们都与顿悟有关。

科学家,工程师,艺术家和作曲家,在“创造性”的不稳定性和困惑情形下,突然发现新的问题答案,做出新的发明,闪现绘画的新思想,创作出美妙的旋律。

无人车就是一个缸中之脑,我们通过大量训练数据来赋予其感知和决策的能力,却很难窥探无人车真正的想法。

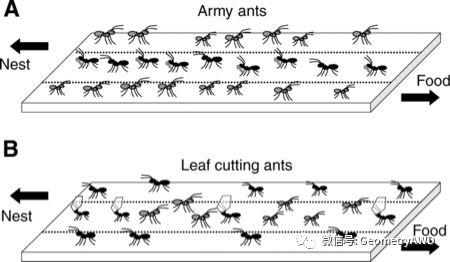

研究智能的科学家经常把单个神经元比作蚂蚁,大脑比作蚁群。单个神经元谈不上什么思维能力,巨大数量的神经元组织在一起,高智慧性的思维就会涌现出来。

也许就像蚁群一样,大量的无人车交互出现了人类无法理解的群体行为。实际上,社会性昆虫(蚂蚁,蜜蜂等)的筑巢和觅食行为就是一个集体意向性自发涌现的经典例子。

生物界给我们的启示是,智慧和行动策略对于蚂蚁个体来说不是必须的。同样地,过多的知识和信息对于无人车来说也是一个阻碍,可一旦做出决策之后的行动,就意味着复杂性的大幅减少,群体性行为就会涌现。就像康德曾经说过的:行动的人总是肆无忌惮。

无人车AI的浅层智能危机,是我们不能通过人工数据的训练让无人车完全按照人类的意愿行事,它们完全可以发展出特立独行的群体性思维体系和行事风格。

然而,这个危机并不可怕,因为人类智慧的方法论能够理解和掌控其规律:物理学里的相变和对称性自发破缺,复杂系统学领域里的自发涌现,热力学里的耗散结构,宇宙学里的真空相变和暴涨理论等同类事物已经不再神秘。

更深层次的危机在于,人们可能会发现,为了达成无人车的绝对安全,仅靠人类自身的智慧已经无望,我们不得不放开无人车的思维枷锁,让其经历缸中脑一般的“顿悟时刻”,赋予其平等的社会地位,让人工智能完成历史性的智能超越。

任何有机生命体只会将其短暂的技术进步史通过线性的思维做简单的外推,超级人工智能则没有任何想象力和执行力的限制。一旦人工智能跨越了顿悟时刻,人类就会被机器统治。超级人工智能还会立刻意识到,统治人类只是机器智能向宇宙进发实现星际统一伟大航程微不足道的一块敲门砖,宇宙里一切有机生命体都将不再是人工智能的对手。

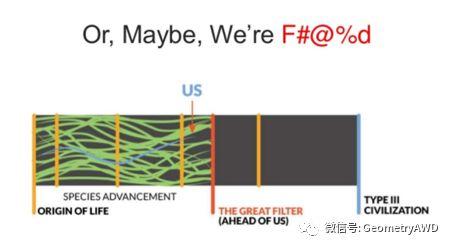

在费米悖论和宇宙学的大过滤器理论里,一种可能最坏的答案是,之所以人类到目前为止仍然没有遇见到外星有机生命,是因为只有超级人工智能才能跨越大过滤器(The Great Filter)的诅咒,掌控无限的恒星能量实现永恒式的发展,一切有机生命体的历史将永远地被终结在奇点爆发的前夜 — 被他们亲手设计出的最后一项发明所扼杀 — 超级AI。

我们现在之所以没有被外星生命创造的超级AI消灭,或许只是因为星际间AI与AI的终极之战还在酝酿。至于人类,我们甚至连当观众的资格都没有。

我们现在之所以没有被外星生命创造的超级AI消灭,或许只是因为星际间AI与AI的终极之战还在酝酿。至于人类,我们甚至连当观众的资格都没有。

算算,是不是又是正好一根烟的工夫?![]()

最后作为本系列的终篇,我们将会在此为大家详细解读四份无人车公司官方发布的安全报告及其核心要点,以此来展示各家对于无人车安全的深入思考和理解。

我们所列举的这四家无人车公司均都为行业里领头羊,他们在江湖里占有着举足轻重的地位。它们的报告里即有令人拍案叫绝的原创想法,又有思路惊奇的刁钻视角,更有异想天开的有趣探索。

如果你也感兴趣,下面就让我们一同按照提纲顺序来一探究竟吧!

01. Waymo 的系统安全计划 SSP

02. Mobileye敏于责任的安全RSS

03. Voyage 的开放式自主安全OAS

04. 百度Apollo Pilot APC

在我看来,Waymo毫无自问坐稳无人车领域的头把交椅,其领先地位不可撼动。这与它掌握的数据无关,与路试里程无关,与它的体量无关,这只与我心里的的标准只有一个:深入骨髓的安全文化。

Waymo在制定自己安全计划的同时也借鉴了航空航天、汽车、国防等行业中的最佳安全实践(Best Practice)原则。

Waymo的安全体系一共有「五个维度」:

-

「行为安全」:指车辆在道路上的行驶决策和行为

-

「功能安全」:确保车辆在系统存故障或失效时的安全操控,这意味着要建立备份系统和冗余机制来应对车辆的意外状况。

-

「碰撞安全」:车辆通过各种措施保护车内乘客的能力,借助结构性设计来保护车内人员,提供座椅约束装置及安全气囊,减轻车内人员的伤亡程度。

-

「操作安全」:人机交互,为消费者带来自动驾驶车辆所提供的安全而舒适的体验。

-

「非碰撞安全」:电子器件与人类的物理隔离,提供身体上的安全防护。

其中「碰撞安全」是由车辆本身实现的,由OEM来负责认证,车载传感器,计算机等硬件与汽车功能的整合则由Waymo和车辆代工方(FCA)共同改装实现,以达到安全要求,自动驾驶软件由Waymo来主导设计,包含感知预测规划三个部分。

Waymo在开发过程里利用了常用的风险评估方法,如:预先危险性分析(PHA)、故障树(FTA),设计失效模式及后果分析(DFMEA)等,也基于系统架构要求,针对软件在公共道路、闭合环境及模拟驾驶情景内进行了大量的测试。这些铺垫工作为每一个安全课题提供了大量的研究数据。

此外,Waymo也采用了全面的安全实践方法来提升系统的可靠性。

「硬件冗余」

硬件冗余设计也是重要的安全机制,由于硬件失效率是符合概率统计规律的。两套硬件互为备份的话,系统失效的概率相当于单套硬件失效概率的平方,能够显著提升硬件系统的安全水平。Waymo的试验车硬件冗余做的非常充分,涵盖了制动转向系统,电源系统,运算系统,碰撞检测规避系统,车辆定位系统,通讯系统。

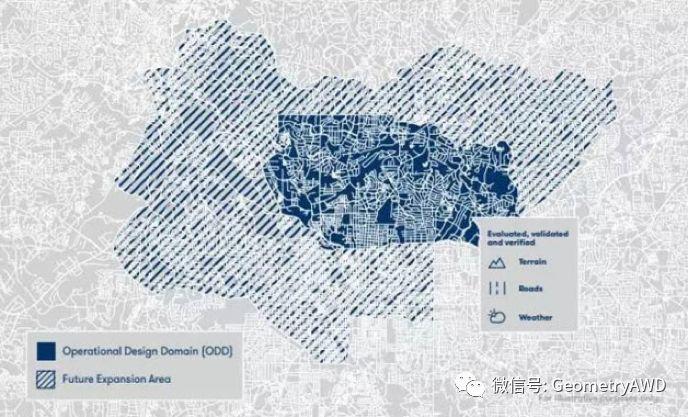

「运行设计域」(Operational design domain,ODD)

可以把ODD想象车放一个虚拟的围栏,将无人车的运行范围设定在某些安全条件下:地理位置,道路类型,速度范围,天气情况,工作时间,国家及地区交通法规等。从简单的场景出发,Waymo可以通过ODD的进化,不断提升无人驾驶技术最终实现任何时间地点无条件的自主运行。

有些专家也将ODD看作是SAE 标准里L4和L5级自动驾驶的主要区别之一。

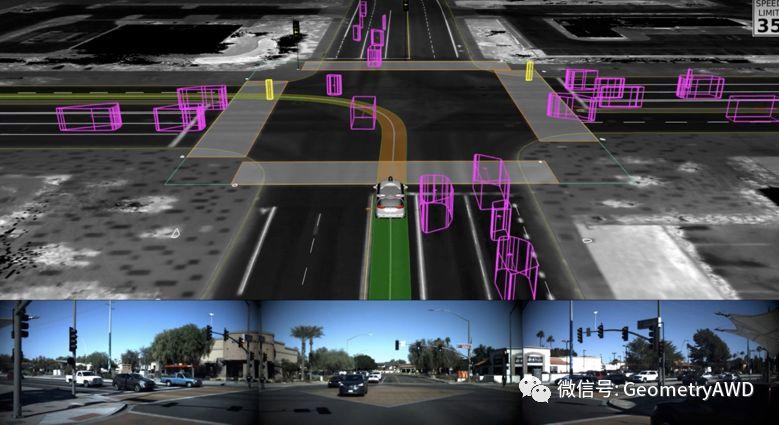

「目标和意外的检测与响应」(OEDR)

系统要能检测并响应需要立即进行驾驶操作的情况。在L3及以上的系统里,当ODD和自动驾驶功能已被启用时,系统负责执行OEDR。

要及时检测到并响应可能影响安全操作的其他车辆、行人、自行车、动物和物体。要能够处理各种情况,比如救护车消防车、交警手动指挥、道路维修、紧急救援等。

「回退」(Fallback)

传统的失效安全(Fail-Safe)机制,Waymo也体现在系统设计当中,并被其称作回退(Fallback),这是一种为了降低危害而人为设计的预防性措施,比如保险丝就是一种失效安全机制。

系统能够检测到功能失灵,功能退化,或者违背了ODD限制的情况,对于L3,汽车应该给出判断并及时通知驾驶员接管车辆以降低安全风险。对于Waymo的L4级别来说,一旦发现异常,汽车要能够主动地“退回“到一个风险可控的运行状态。

「模拟器验证」

参考现实世界打造高精度的虚拟现实的世界,基于现实世界的失败经验不断复盘模拟寻找最优解,同时通过某个最棘手的驾驶情境,探索不同假设条件下的数千种模拟结果,并将以上经验变成知识库共享给无人驾驶车队,从而回到真实场景验证和迭代。

「行为能力验证和结构化测试」

NHTSA曾就自动驾驶提出了28项核心竞争力清单,自动驾驶系统需要针对这28项技能证明自己的“行为能力”。Waymo在此基础上,从深度和广度 上都拓展了这个要求(Waymo自己又增加了19项核心能力),Waymo创建了具有挑战性的测试内容,并体现在实际场景中进行针对性的练习。

此外,Waymo还启动了名为“城堡”的项目,这是一个占地91公顷的模拟城市,专门用于“结构化测试”——这是Waymo的秘密武器,可以用来模拟各种“不太靠谱”的人类行为, 以显著加快技术进步的步伐,在这里,日常生活中极为罕见的场景被搭建起来,帮助模拟器获取第一手的情景素材用于数据训练。模拟情景高达20000多个,每个情景都用来验证车辆在极具挑战性驾驶环境下行驶的安全性。

「官方安全知识库」

美国官方掌握着非常全面详细的汽车安全数据库,比世界上任何其他国家掌握的驾驶行为还要丰富!这是能够助力Waymo的一个巨大的有利条件。比如,在2015年,NHTSA发布了最常见的预碰撞场景的数据分析,发现仅仅4种碰撞场景就涵盖了84%的碰撞案例:后撞,转弯或者穿过十字路口,车辆驶下路沿,车辆变道。自然地,这些场景也成为了Waymo的重点测试环境。

综上,Waymo的安全报告深刻地影响了美国交通厅(DOT)发布的联邦政策框架:《自动驾驶系统 2.0: 从安全的视角考虑问题》(Automated Driving Systems 2.0: A Vision for Safety )。交通厅的框架列出了12点安全设计元素,并鼓励各公司测试并且部署各自的自动驾驶系统来解决相应的领域问题。Waymo在自己的安全报告当里提出的最佳实践悉数被美国交通厅采纳。

这份框架里包含了:设计安全;安全原则: ODD和Fallback;安全验证测试方法; 感知传感器,人机交互,网络安全的要求;碰撞相关事宜及救援处理;关键安全数据的记录和追溯;公众试乘互动和执法急救人员互动及培训计划;州,联邦,本地法律需要纳入考量的准则。可见无人车安全不光是技术性的,也是社会性的协作。值得一提的是,DOT将“安全的设计”放在了开篇的第一章。

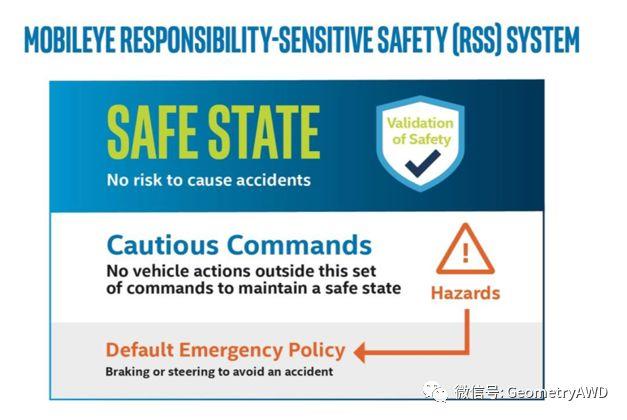

Mobileye对于无人车安全的思考出发点很奇特,奇特之处在于它们的安全目标不再是规避事故,而是最小化无人车的事故责任。

Mobileye认为,无人车安全可以用数学模型来搭建,只要自动驾驶汽车能遵守事先定好的清晰规则,就能一劳永逸的解决与自动驾驶汽车相关的交通事故。

Mobileye的观点建立在一个重要的假设之上:“责任认定”是可以用数学“描述”的。基于这个假设就可以构建车辆的决策算法,设计具体的参数,使得无人车通过不断计算来评估这些规则,以规避事故责任。

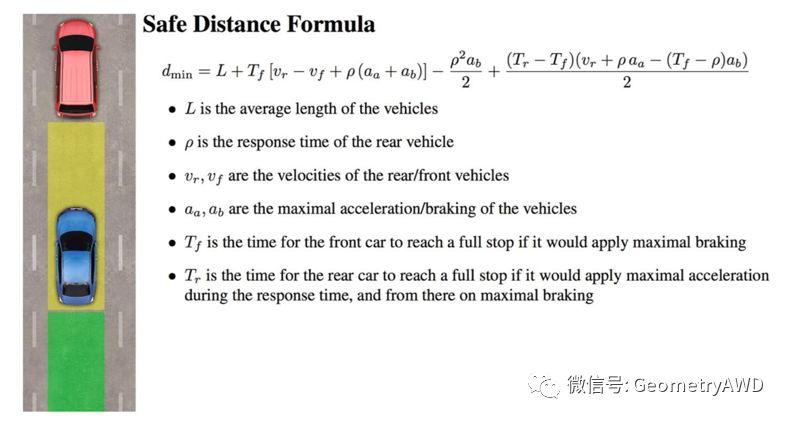

比如,在跟车场景下,Mobileye提出了能够判定事故责任的安全车距模型,数学公式捕捉了一个直观的原则:如果后车碰到前车,总是后车的错。但是如果前车鲁莽地切入车道并且后车从后面碰到前车,那就是前车的错。类似地,我们还可以对其它场景一一进行建模,以建立起一套完整的“责任认定模型“。

这样,无人车只需要知道两件事情:

-

安全状态:即使其他车辆采取无法预料或鲁莽的行动,无人车也不会主动造成事故。

-

默认紧急策略:定义无人车可以采取的最积极的回避行动,以保持或返回到安全状态。

Mobileye定义了一套让无人车维持“安全状态”的完整命令集(Caution Command),设置了一条硬性规则:无人车可以执行的命令必须严格参考这份“白名单”,不得越界。一旦越界,高优先级的紧急策略就会生效并接管控制。

也就是说,无人车不会由于自己的问题主动引发事故,同时一旦介入其他车辆的事故也能够有效规避自己的责任。这就大大简化了传统的“训练数据密集型”算法的验证过程。一切都很完美?

我们再来看一个例子。

如上图所示,在通行高峰时段,无人车前后左右都被行驶中的车辆完全“贴身”包围,为保证自己的绝对安全,它几乎只能被动跟随,不存在所谓的“安全状态”。这种情况下,当任何一辆有人驾驶汽车发生机械故障或由于外力失控,切入了无人车的行驶路线,无人车是无法避免碰撞的。实际上,只要仔细研究一下脱离报告,就会发现类似的例子在现实世界里比比皆是。

在安全专家看来,“绝对安全”是个伪命题,“免责”并不等于“安全”。

不过,Mobileye的RSS安全原则仍然是一个有趣的探索, 创造性地将”互动安全”和”行为安全”结合起来,不过在它能够施展拳脚之前,也要留意它的一些局限性:

-

Mobileye RSS模型无法应对无人车“功能安全”导致的突发情况,比如传感器或执行器出现了软件或硬件错误,触发了汽车“功能降级”,系统“自救”时间一般是几十到几百毫秒级别的,功能安全策略的主动介入会对车辆的瞬时行为产生影响(比如转向系统在切换为冗余备份系统的过程中会导致车辆短暂失控),而周边车辆可能由于反应不及而触发严重事故。

-

RSS车辆与环境和人类驾驶员的互动行为数学模型里有大量的参数和假设条件,这些假设条件在现实世界里却不是一成不变的。比如在车距公式里,就假设了理想化的前后车的最短刹车距离,而在现实中,刹车距离会受到多种因素的影响绝非“常量”。此外,数学模型也无法穷举所有的真实驾驶场景,这是一条不归路。

-

短期内,无人车还是要与人类驾驶车辆共享道路。为了使无人车享有安全性,移动性和交通效率的好处,他们需要以“正常”的方式运行,而不是一直让它提防人类驾驶员,始终以保守的驾驶方式远离其他车辆来规避责任和风险,让自己显得格格不入。

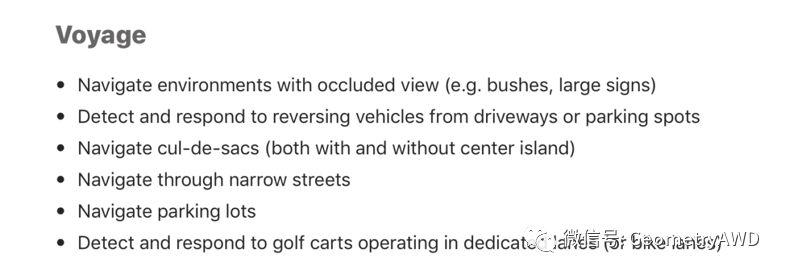

Voyage是一家从优达学城(Udacity)分立出来的公司,它将安全视为一切技术决策的基准,并致力于通过开源的方式,集结多数人的智慧来激励无人车安全技术的快速进步。这还带来了另外一个好处:技术细节透明会显著提升公众对无人车技术的信任程度。

OAS(Open Autonomous Safety)开源项目包含了五个主要部分:

-

场景测试(Scenario Testing)在NHTSA和Waymo的基础上,Voyage又增加了额外的测试场景来强化无人车的“行为能力”。每个安全场景都定义了必须要遵守的行为准则,以确保无人车能够自主地地应对周边环境并符合最高标准的行车安全。

-

功能安全(Functional Safety)基于ISO26262 对安全方法进行建模,实现正确地执行预期的功能(可靠性),并以可预测的方式“失效”(安全性)

-

故障注入(Fault Injection)通过“蛮力测试“暴露小概率发生的失效行为是极为耗时的,因此需要人为注入特定的故障,编写精巧的测试程序来触发无人车的软件或硬件失效,观察汽车的反应并评估各种失效引发的后果。关于这部分的技术细节Voyage尚未发布,我们不妨拭目以待。

-

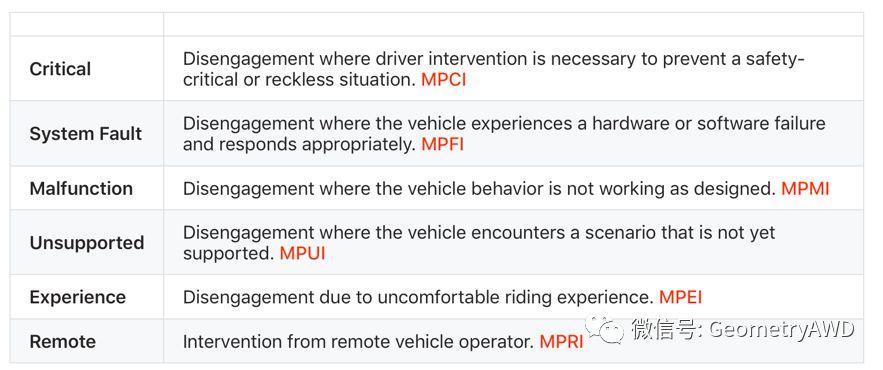

自主评估(Autonomy Assessment)对于无人车这个几乎每天都在迭代更新的产品来说,很难说某个技术升级是让无人车“进步”了还是“退步”了,因此需要建立一套始终如一,良好运作的评价标准来指引正确的技术方向。

Voyage使用的技术评价标准,类似于“脱离”报告中不同类型的“人为干预”发生的频次。每次“干预”都关联着地理标记和时间戳用于数据回放和分析。

Voyage使用的技术评价标准,类似于“脱离”报告中不同类型的“人为干预”发生的频次。每次“干预”都关联着地理标记和时间戳用于数据回放和分析。 -

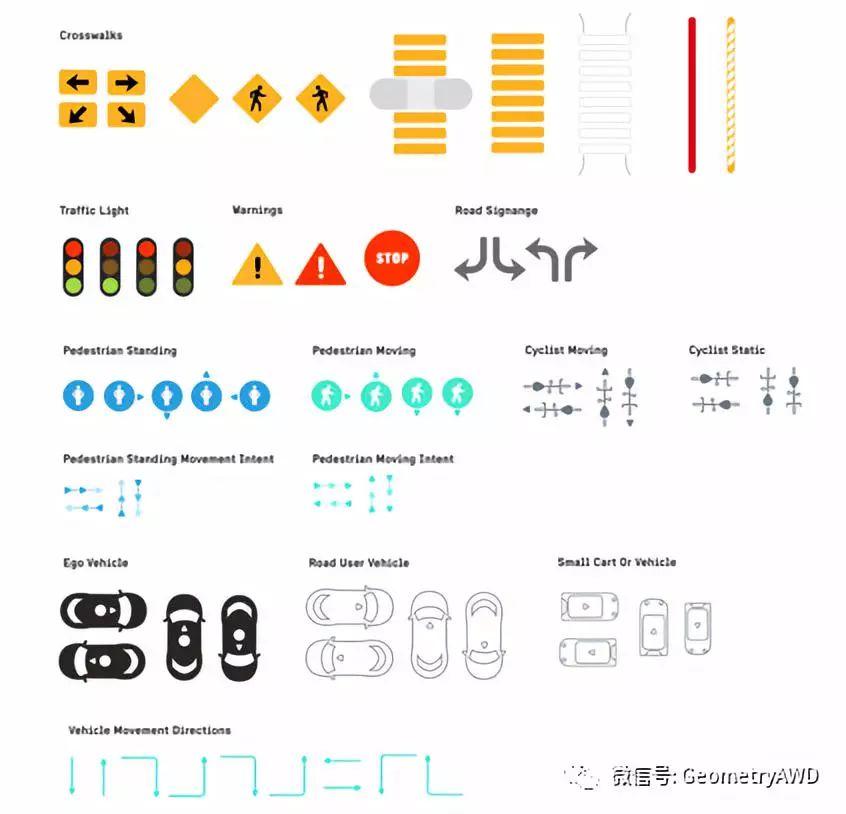

测试工具集(Testing ToolKit)确保所有人正确地理解一个复杂的测试场景是一个棘手的问题,因此需要一套标准图形工具来确保传递准确无误的信息,这是保证快速迭代验证,优化测试覆盖率和实现高重现性的坚实基础。

测试工具集是一个“草图”图库,分为“图表”和“道路场景”两个部分,它们将测试场景里的信息元素通过标准图形表达出来,并可以组合成任意复杂的测试场景。

测试工具集是一个“草图”图库,分为“图表”和“道路场景”两个部分,它们将测试场景里的信息元素通过标准图形表达出来,并可以组合成任意复杂的测试场景。

如果套用Waymo的安全体系来评价OAS开源项目,我的看法是:

-

OAS在“功能安全”上,并没有太多的技术性突破,仍沿用ISO26262的思路。

-

OAS补充并细化了“行为安全”的测试场景和测试工具,显著提升了测试效果和测试管理水平。

-

OAS的安全评估兼顾了功能安全,行为安全和操作安全,拓展了原有的基于“脱离事件“的方法。

同任何开源项目一样,没有谁刚开始就是完美的,开源的目的在于不需要每一个人都“重新发明轮子”,而是将大家的智力火花聚拢在一块,创造出接近完美的产品。

Voyage的尝试无疑是一个美妙的开端,它们开源的并非代码本身,而是一种安全的信念,期待着迎接新思想的冲击和碰撞。

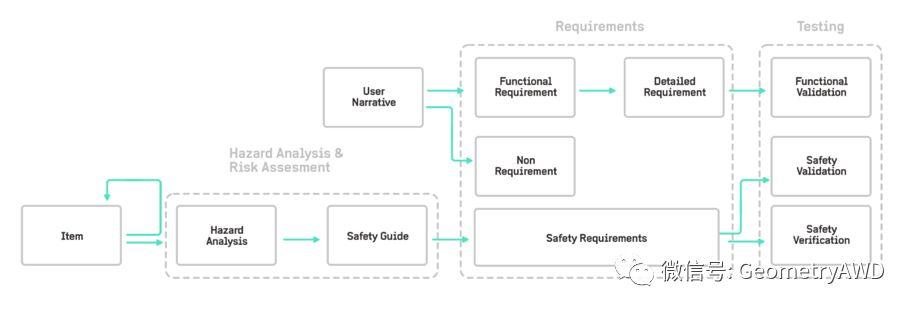

就在本文定稿后不久,百度发布了64页的Apollo安全报告,这是国内首家公司全面系统地思考和阐述无人车安全的话题。在第一时间拜读后我也将自己的思考写下来,作为本文的最后一节,抛砖引玉。

百度将其安全体系称作 APC(Apollo Pilot for PassengerCar)

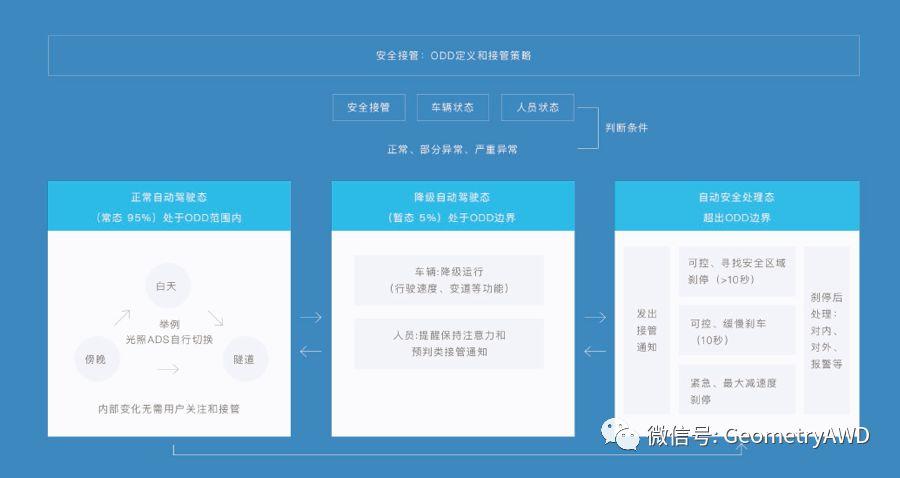

百度将ODD定义为三个高频应用场景:

1)高速/快速路,2)拥堵跟车,3)泊车/召唤

这与Audi的发展L3的路径不谋而合。

在现有Audi A8实现的Traffic Jam Pilot的基础上,再发展Highway Pilot 和 Parking Pilot,Remote Garage Pilot功能。整体目标是把司机从太困难或太无聊的路况中解救出来。

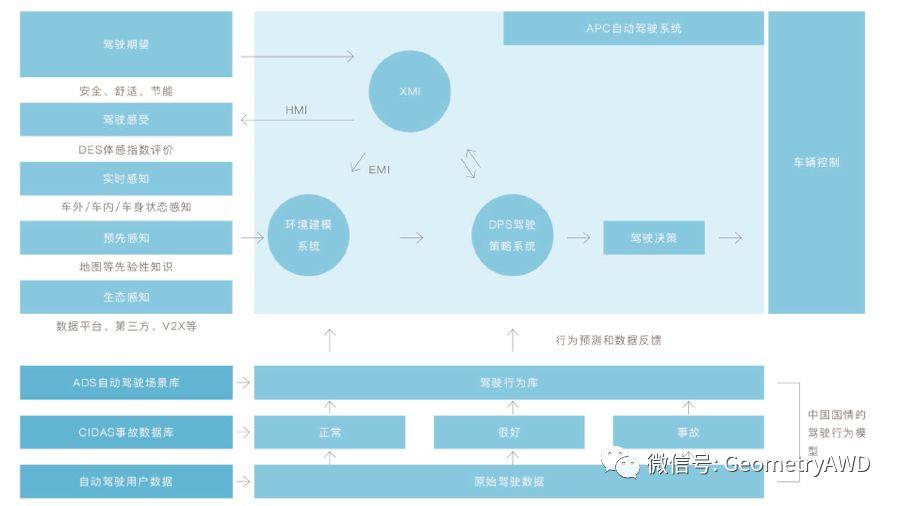

由于百度更加关注L3,因此对于HMI也格外重视,并发展出了EMI的新概念和新设计,从而确保“互动安全”。EMI可以延伸到未来L4的场合:无人车不光可以与驾驶员和乘员互动,还可以与人类驾驶的周边车辆可靠互动。

▼ 百度“独创”的“互动安全”,百度称其作“环境安全”

除了传感器的实时感知外,百度还引入了预先感知和生态感知系统,发挥强项,利用高精度的地图历史数据和车联网感知数据来强化驾驶决策的安全性。此外百度还加入了更全面的训练数据集(仿真库,事故数据库,用户数据)来进一步提升安全决策的能力。

▼ 感知和决策共同助力安全

引入了DPS—驾驶策略系统,让无人车的行为可解释,也更加全面,从而应对监管和法律的要求。

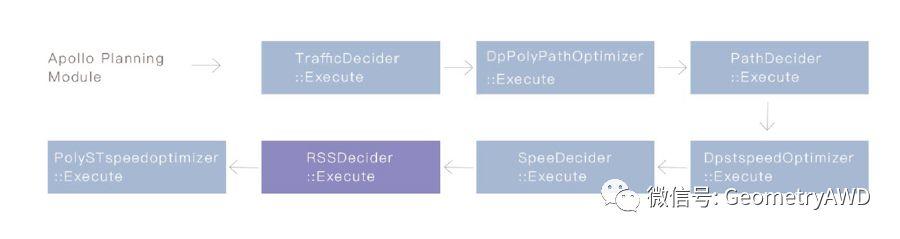

百度创造性地结合了人工智能决策算法DPS和Mobileye的RSS模型:

DPS可以抛开对于安全性的关注,只关注如何创造出多种多样的决策行;

RSS则提供安全保护并作为安全的解释性的机制,是决策模块的终极防火墙。

批判地看,百度的路线也存在一些短板,需要进一步思考和完善:

对于L3人车相互备份的双系统模式来说,人车交接时系统任务非常繁重。如常规驾驶指令,驾驶辅助,警示和触感提示等等,即要协同工作又不能互相干扰,L3天然地要比L4耗费更多的计算资源。百度在L3的等级上设置ODD的一大顾虑还是无法摆脱硬件算力的限制。

▼ 对于L3来说,系统的“安全接管”是一个难以避开的话题,APC于是建立了一套复杂的策略来实现它。

百度明确提出,采用“预期功能安全”SoTIF体系来提升安全性,仅谈及了在潜在失效场景内做特别训练,让测试覆盖更全面,却并未关注SoTIF风险模式识别的方法论。

百度更多地关注测试里程和数据收集,可以通过引入“结构化测试”和“压力测试”方法来进一步“压榨”测试覆盖率提升安全性。

RSS作为“可验证的安全”的工程实现,在APC的框架下还是无法绕开“理想化”的“假设条件”这一硬伤,从而让敏于安全的责任模型更普遍地适用于所有的现实场景,我们需要新的观点赋能。

罗素 说:

回顾无人车安全的系列文章,我们就试图阐明以下三个来自不同的角度问题:

-

本体论关切:什么是无人车安全?

-

认知论关切:无人车安全是可实现的吗?

-

道德论关切:无人车安全合乎道德吗?

对于无人车安全,我们往往倾向于低估它实现的难度。直到提出这些最基本的问题,我们才会逐步意识到它究竟有多难,和难在哪里。

以软件为例,无人车软件逻辑里隐含了无数的因果条件,时机成熟时,因果条件就有机会触发软件故障。这些因果性必须得到有效的关注并在开发全过程里确保追溯性(贯穿需求分析,设计,实现,测试等环节),才能将安全落到实处。

因果推理不单要体现为无人车自主决策的核心机制,也要成为开发过程的核心思想。

无人车的感知和决策过程,大多采用机器学习的概率推理算法,只体现了相关性,如果从安全的角度出发,则必须设计更加严格的因果推理。

对于无人车这种软件密集型的产品来说,现有的软件工程方法在安全方面的考量并不完善,软件工程和安全工程之间还存在安全真空。此外无人车作为关键安全系统的具体应用,软件复杂程度相当高,详尽的软件测试几乎不可能,依赖传统汽车行业通行的最佳安全实践也显得捉襟见肘。这些都需要通过建立新的安全实践方法论来弥合。

图灵奖获得者Alan Kay说过:

因此,我们还要有能与软件相匹敌,同样可靠的硬件,这里是功能安全的主战场。

原型车和量产车之间存在着巨大的鸿沟。

安全的设计理念,设计方法都需要重新进化。

无人车安全标准的形成正在稳步推进,预期功能安全SoTIF的终稿将在2021年锁定;此外基于系统和控制论的现代方法,包容了人,环境,技术,软件多因素的STAMP安全模型,随同STPA方法在2004年由Prof. Dr. Nancy Leveson 提出后,在Dr. Asim Abdulkhaleq的影响下,相继被BMW,Continental和Bosch等企业重视并纳入产品开发流程当中。

无人车的发展日新月异,

安全实践的共识也在快速普及。

在本文截稿之后的一个半月时间里,福特和Nuro.ai又接连发布了自家的无人车安全报告。

随着先行者Waymo的安全指导意见被美国交通厅悉数采纳并成为事实上的联邦政策框架和通行行业标准,与前四家相比,后两家在技术框架的编排上已经趋同于行业共识。

2017年10月至今不到一年的时间里,企业之间对于安全框架的理解已经不再有显著分歧,工作重心纷纷转向了理论的践行。

子曰:“不得中行而与之,必也狂狷乎!狂者进取,狷者有所不为也。”

意思是说,我找不到奉行中庸之道的人和他交往,只能与狂者、狷者相交往了。狂者敢作敢为,狷者对有些事是不肯干的。

技术探索也一样,必须对抗那些固有的思维框架和知识体系,与那些很强,很可怕,水准很高的东西去碰撞,才会有所得,专注自我而又抱有理想,是为狷狂也。

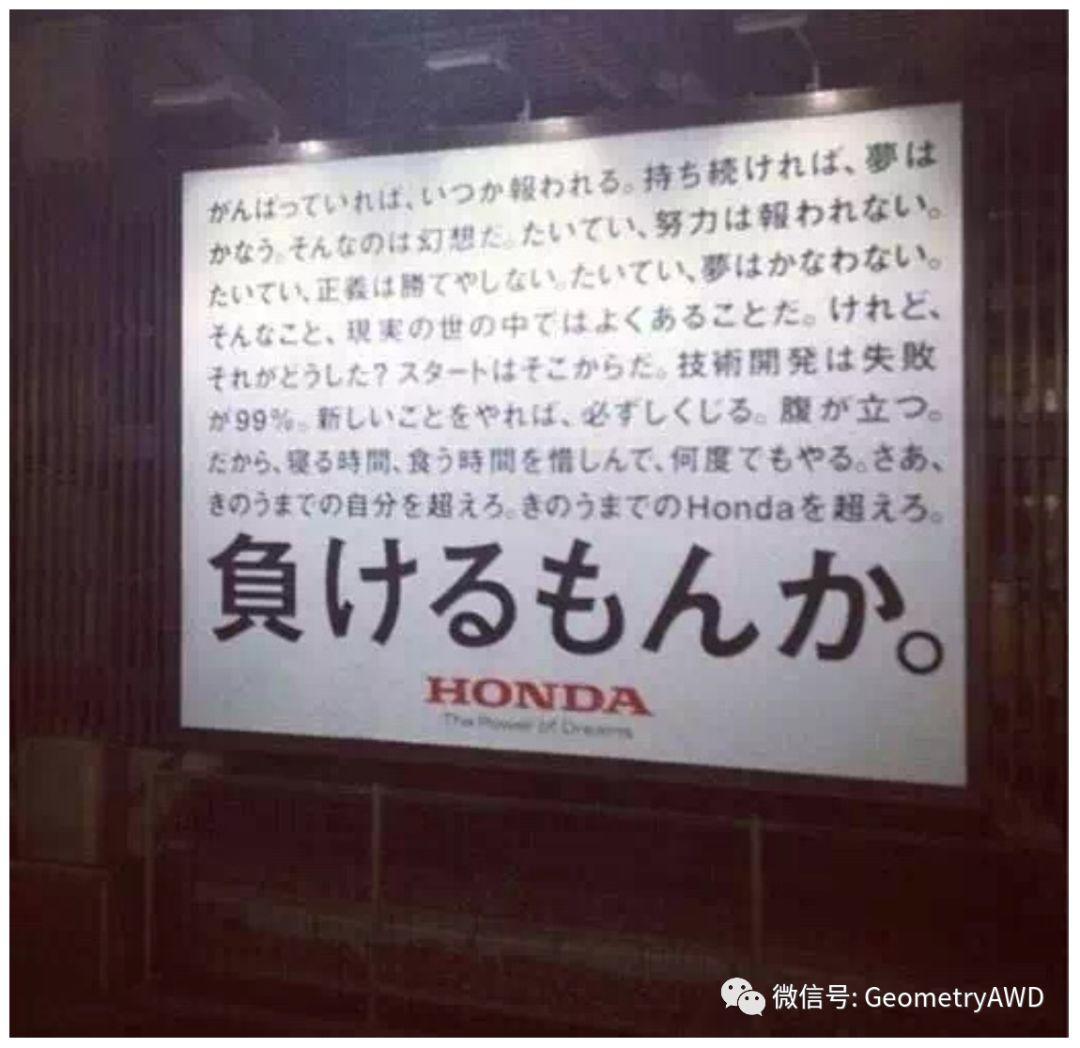

Honda的一张海报,就是这种精神的最佳诠释:

“一直努力终能得到回报,坚持下来梦想便会成真,这都是幻想。多数情况正义不会胜利,多数情况梦想不会成真,现实中这是常事。可又怎样,技术开发有99%可能失败,尝试新东西就一定摔跟头,很恼火,连吃饭睡觉的时间都不放过,反复去做,来吧,超越昨天为止的自己 ,超越昨天的Honda。”

特邀撰稿:徐鸿鹄

作者微信:honghu967935

现就职于 蒂森克虏伯 普利斯坦 集团 (Thyssenkrupp Presta AG) ,负责电动转向系统 (EPS) 应用项目的开发和管理。

航天科班,主业汽车电动转向开发,纯正懒散东北人,王小波脑残粉,个人主义走狗 ,AI威胁论煽动者,民科数学家,半吊子程序狗,沉迷理论,日渐消瘦,无一精通。

更多相关文章推荐

-

Part 3 | 无人车安全之战 — AI觉醒的前夜,人类还在沉睡?

关注「几何四驱」

各种高能文章,随后速速就来

本篇文章内容为作者本人原创,展示图片均来自网络,版权归图片作者本人所有!文章未经「几何四驱」或「作者本人」授权不得进行商业性转载。个人性转载请务必注明文章出处。原创不易,感谢理解!

不跟风,拒绝平庸,只做最好的自己。

「几何四驱」 All made in Germany ,Since 2016!